SEnet 通道注意力模块

分类: 人工智能、学习笔记 2556 0

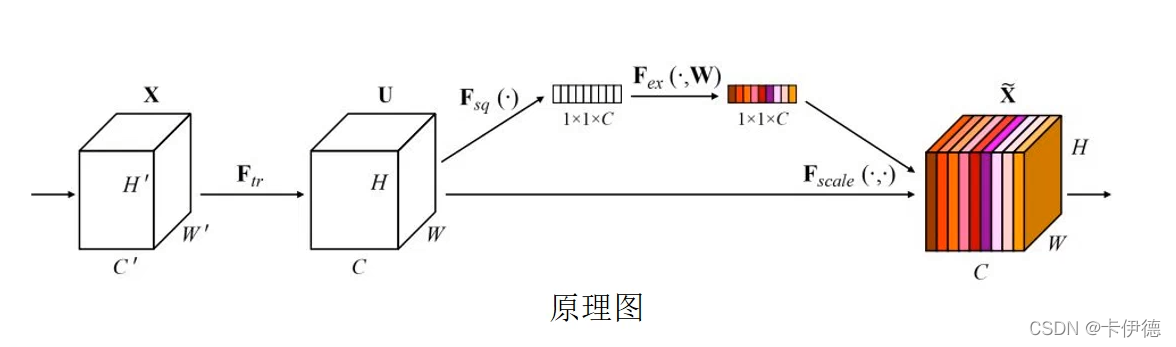

开篇一张图:

变量和图片解释:

三个正方体:特征向量,比如说图像的特征,H表示图片高度、W表示图片宽、C表示通道(黑白1通道、彩色3通道)

字母:

- X表示输入特征;

- Ftr表示的是对X进行一次卷积,也就是对特征进行一系列的操作之后的结果,表示为U;

- Fsq(.)表示的是对U进行压缩;

- Fex(.)表示的是对U进行激活(就是赋予权重);

- Fscale(.)表示的是对U进行放大(就是恢复维度);

执行过程

- 对于输入的特征X进行一些列处理(在图中表示为卷积:Ftr)之后,得到处理后的特征U。

- 对特征U进行压缩操作,该压缩是沿着通道进行的,说直白的就是把每个通道的向量变为一个1x1的向量,也就是一个数,再直白一点就是把C个高为H、宽为W的一个平面面变为C个点。得到1x1xC的向量。值得注意的是:每个数(点)都拥有这个通道的全局特征信息。

- 然后使用可学习的参数对前面得到的1x1xC的向量赋予权重,说白了就是给C个点分别给一个权重,表示这个点在整个特征中的重要性。图中不同的颜色表示不同的重要性。

- 根据第3步的C个颜色对应到原始特征上,把原始特征的C个通道染上对应的色(赋予对应的权重)。这就得到了不同通道的不同的重要性,也就是注意力。

总结

这是我学完SENET之后的个人理解,傻瓜式理解,不喜勿喷。

需要注意的是,这个模块非常的灵活,非常的通用,如果想水一个创新点,往已有模型里加东西,这个模块可能是一个不二之选。

最后附上代码和网络结构图(对着前面模型结构图能看懂),如果模型结构懂了,看代码就是时间问题。

在图中根据上面说的对应着应该能看懂,需要说明的是r是一个给定数,主要是怕C太大,参数太多。

源代码:SEnet.pytorch 有caffe实现的,但是配一个caffe环境,我能重装十个系统,尽量用pytorch吧。

核心模块代码(对着网络结构图看看能懂):

from torch import nn

class SELayer(nn.Module):

def __init__(self, channel, reduction=16):

super(SELayer, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.fc = nn.Sequential(

nn.Linear(channel, channel // reduction, bias=False),

nn.ReLU(inplace=True),

nn.Linear(channel // reduction, channel, bias=False),

nn.Sigmoid()

)

def forward(self, x):

b, c, _, _ = x.size()

y = self.avg_pool(x).view(b, c)

y = self.fc(y).view(b, c, 1, 1)

return x * y.expand_as(x)

共 0 条评论关于 “SEnet 通道注意力模块”