人工智能 因果学习篇(2)-Causal Attention for Vision-Language Tasks(文献阅读)

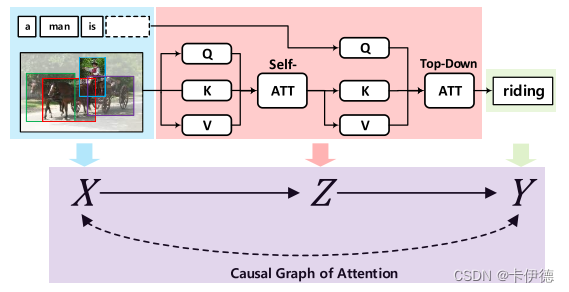

Causal Attention for Vision-Language Tasks 引言   这篇论文是南洋理工大学和澳大利亚莫纳什大学联合发表自2021年的CVPR顶会上的一篇文献,在当前流行的注意力机制中增加了因果推理算法,提出了一种新的注意力机制:因果注意力(CATT),使用因果推断中的“前

Causal Attention for Vision-Language Tasks 引言   这篇论文是南洋理工大学和澳大利亚莫纳什大学联合发表自2021年的CVPR顶会上的一篇文献,在当前流行的注意力机制中增加了因果推理算法,提出了一种新的注意力机制:因果注意力(CATT),使用因果推断中的“前

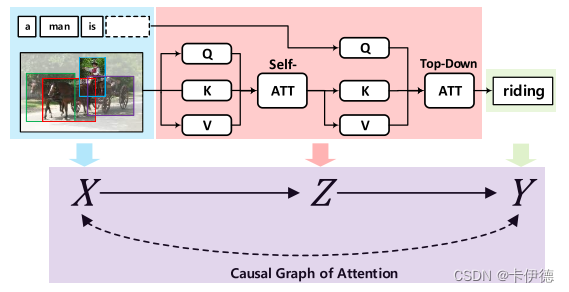

Hierarchical compositional representations for few-shot action recognition 文章于2023年发表于CVPR会议上的一篇论文。该会议是计算机视觉任务中的TOP会议。 论文地址:https://arxiv.org/abs/2208.09424 开源地

Deep Neural Networks in Video Human Action Recognition: A Review 本次分享的文章是2023年收录在计算机视觉领域的顶刊“CVPR”(级别:视觉类TOP)期刊上。该期刊详细信息可关注公众号 AI八倍镜 点击菜单项查询。 论文地址:https:/

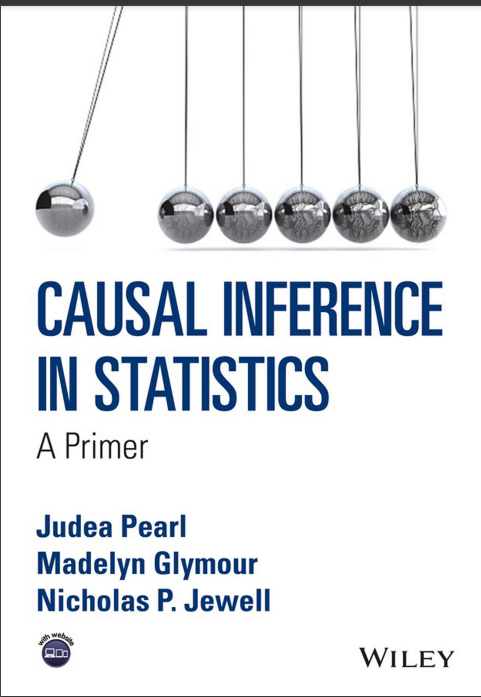

后门准则 本次分享的知识来源于《Causal Inference in Statistics:A Primer》的翻译版本《统计因果推理入门》,该书由杨娇云等人翻译,主要包括因果学习的基础知识。 电子图书获取方法: 关注公众号“AI八倍镜”并回复“因果学习”。 知识回顾 在上一小节“校正公式”当中,学习到

前言 在不同的程序中通常会使用不同的导包方式,如 from pyemd import emd from PyEMD import EMD 错误 如果按照网上的办法 什么pip install PyEMD或者pip install EMD-signal等。只会造成各式各样的错误,如找不到pyemd、找不到PyEMD、找不

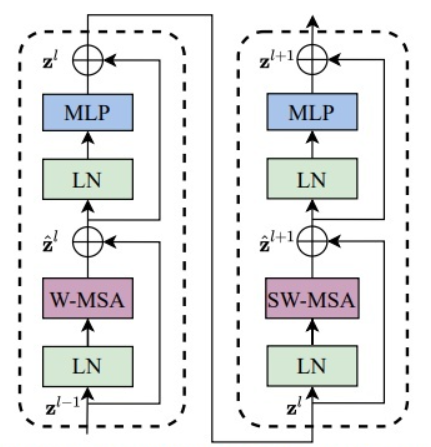

Swin Transformer: Hierarchical Vision Transformer using Shifted Windows 1. 论文信息 原文地址:https://arxiv.org/abs/2103.14030 官网地址:https://github.com/microsoft/S

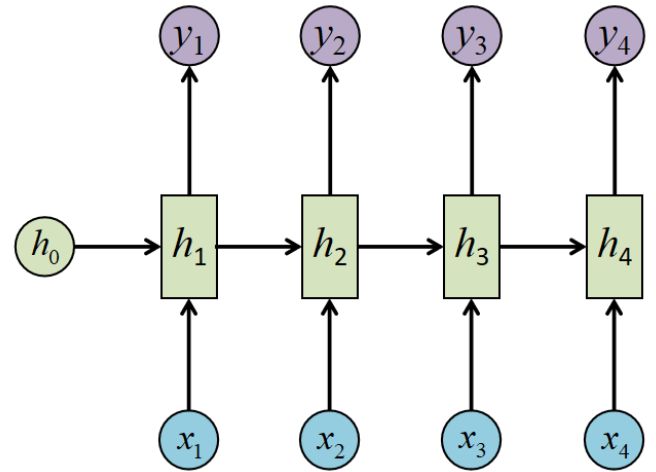

RNN计算公式 RNN结构图结构 图中变量名介绍 a:上一个时间步的激活值(activate value) x :第x个输入(一句话中第x个字) y:第y个输出(预测值) Waa:与激活值进行计算的参数。其中第一个a是指当前参数是计算a(激活值)的,第二个a是指当前参数与激活值进行乘运算 Wax:与输入进

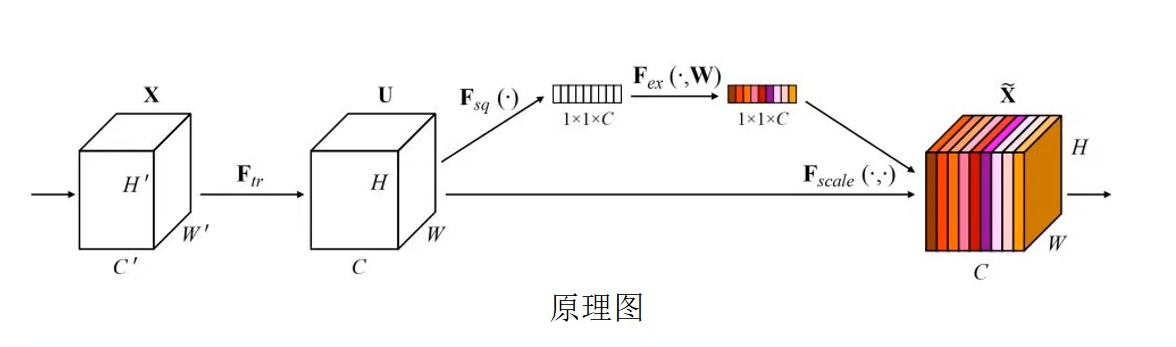

开篇一张图: 变量和图片解释: 三个正方体:特征向量,比如说图像的特征,H表示图片高度、W表示图片宽、C表示通道(黑白1通道、彩色3通道) 字母: X表示输入特征; Ftr表示的是对X进行一次卷积,也就是对特征进行一系列的操作之后的结果,表示为U; Fsq(.)表示的是对U进行压缩; Fex(.)表示的是对U进行激活(

最新评论

张苹果博客

评:友情链接你好博主,麻烦把“VAE+”这个友链删除,已经不用了。更换最新友链地址: 名称:张苹果 网址:https://zhangpingguo.com 图标:https://zhangpingguo.com/logo.jpg 描述:这个人很简单,没什么好说的。

bobo live casino

评:留言我觉得你提到的这个问题很有意思,也很实用。根据我的经验,可能有几个方向可以尝试: 确认一下基础设置:有时候问题可能出在一些小的配置或设置上,可以重新检查一下相关的设置,看看有没有什么遗漏。 参考一些常见问题解答(FAQ)或指南:有时候论坛里其他人可能遇到过类似的问题,查看一下FAQ或者其他人的建议可能能帮助你找到解决方法。 试试其他方法:如果当前的方法行不通,可以考虑其他的替代方案,或者逐步排除不同的可能性来找出问题的根源。

jiyouzhan

评:因果学习篇(2)-Causal Attention for Vision-Language Tasks(文献阅读)这篇文章写得深入浅出,让我这个小白也看懂了!

ccbbp

评:wordpress自动生成站点地图sitemap.xml教程博客很难了,新的百度不收了

楠怪

评:wordpress自动生成站点地图sitemap.xml教程还搞博客呢

clash节点

评:友情链接友链申请 网站名称:clash节点 网站链接:https://clashgithub.com/ 网站头像:https://clashgithub.com/wp-content/themes/modown/static/img/logo.png 网站描述:免费公益SSR/V2ray/Shadowrocket/Clash节点/小火箭订阅链接|科学上网|免费梯子

机灵鬼

评:视频行为识别(一)——综述机灵鬼

评:视频行为识别(二)——小样本动作识别的分层组合表示开心鬼

评:因果学习篇(1)-后门准则写的不错。

BG7ZAG

评:留言你的回复邮件发了两条,估计的插件冲突了,一条是主题自带的评论回复,一条比较简单的文本回复 [图片]